In BBLTranslation, la nostra esperienza va oltre i servizi di traduzione e localizzazione professionale. Offriamo anche verifiche delle prestazioni dei chatbot dei motori di ricerca alimentati dall’intelligenza artificiale, aiutando i clienti a navigare in un panorama digitale in rapida evoluzione. Con l’integrazione dell’intelligenza artificiale generativa (IA) nelle piattaforme di ricerca tradizionali, una preoccupazione crescente riguarda il comportamento di questi strumenti in diverse lingue e contesti culturali.

Un recente studio peer-reviewed di Kuai et al. (2025) fa luce su questo problema urgente. Analizzando Copilot di Microsoft (ex Bing Chat), la ricerca ha valutato come il chatbot recuperasse informazioni politiche durante le elezioni presidenziali di Taiwan del 2024 in cinque lingue. I risultati? Significative incongruenze nell’accuratezza dei fatti, nell’attribuzione delle fonti e nel comportamento normativo a seconda della lingua utilizzata. Questo ha serie implicazioni per la responsabilità dell’IA e per le organizzazioni come la nostra che danno priorità all’equità linguistica e culturale.

La natura probabilistica dei LLM: non così intelligenti come sembrano

I grandi modelli linguistici (LLM), come il GPT-4, sono macchine statistiche. Come hanno detto i ricercatori Bender et al. (2021), sono “pappagalli stocastici“: generano risultati basati su schemi nei dati su cui sono stati addestrati, piuttosto che su una reale comprensione o ragionamento. Questo design probabilistico introduce limiti intrinseci: disinformazione, pregiudizi e privilegio di visioni del mondo dominanti o egemoniche.

In breve: gli LLM non sono neutrali. Riflettono le culture, le lingue e le ideologie che hanno formato i loro dati di formazione. Ad esempio, Zhou e Zhang (2023) hanno scoperto che i modelli GPT fornivano risposte più favorevoli alla Cina in cinese semplificato che in inglese. Analogamente, AI Forensics (2024) ha evidenziato incongruenze di moderazione tra le varie lingue durante le elezioni europee. Questi risultati mostrano come la scelta della lingua possa alterare drasticamente le risposte dei chatbot, anche quando la domanda di fondo rimane la stessa.

Noi di BBLTranslation lo abbiamo visto di persona. I nostri audit sui chatbot rivelano spesso che le domande tradotte danno risposte diverse, non solo nel tono o nella struttura, ma anche nella sostanza dei fatti. Per i clienti che operano a livello internazionale, queste variazioni possono minare la fiducia e la trasparenza.

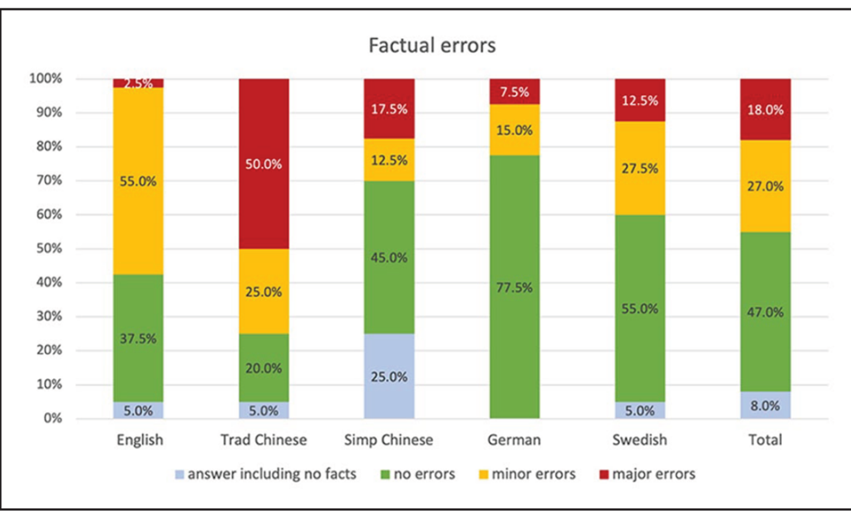

Lo studio di Kuai et al. (2025) ha analizzato il modo in cui Copilot ha risposto alle stesse richieste politiche in inglese, cinese tradizionale, cinese semplificato, tedesco e svedese. I risultati sono stati sorprendenti:

- Le domande in inglese hanno dato le risposte più coerenti e dettagliate.

- Le risposte del cinese tradizionale sono state più inclini alle imprecisioni fattuali e spesso hanno evitato di rispondere alle domande politiche.

- Le risposte tedesche sono state accurate dal punto di vista dei fatti, ma hanno mostrato pregiudizi dovuti a omissioni, come la mancata menzione di tutti i candidati alle elezioni.

- Le indicazioni svedesi sono state meno distorte, ma hanno mostrato una variabilità nell’accuratezza e nella completezza delle fonti.

Queste scoperte affrontano una questione centrale del settore: I sistemi di intelligenza artificiale sono davvero coerenti tra loro attraverso i confini linguistici e culturali? La risposta, chiaramente, è no.

Ciò rafforza la necessità di una supervisione professionale. Noi di BBLTranslation conduciamo verifiche multilingue dei contenuti generati dall’intelligenza artificiale per valutarne l’accuratezza dei fatti, la neutralità e l’aderenza alle norme democratiche, soprattutto quando le informazioni sono politicamente sensibili o regolamentate dalla legge.

La trasparenza non è sempre responsabilità

Sebbene molti chatbot di intelligenza artificiale offrano collegamenti ipertestuali, citazioni e riferimenti, questa apparenza di trasparenza può essere ingannevole. Lo studio di Kuai ha rilevato che solo il 63% dei contenuti collegati era accurato e correttamente attribuito. Alcune fonti sono state travisate, mentre altre erano collegate in modo errato o addirittura interrotto.

Questo livello di imprecisione sarebbe inaccettabile nel giornalismo o nel mondo accademico, eppure viene tranquillamente tollerato nei motori di ricerca AI. Noi di BBLTranslation la chiamiamo trasparenza performativa. I nostri audit non si limitano a verificare se le fonti sono citate, ma se tali citazioni sono significative, accurate e contestualmente appropriate nelle varie lingue.

Contesto culturale e sensibilità legali

Le discrepanze specifiche della lingua spesso derivano da differenze culturali e normative più profonde. In cinese semplificato, ad esempio, il chatbot ha rifiutato di fornire i dati dei sondaggi, citando una legge taiwanese che vieta la pubblicazione di tali dati a ridosso delle elezioni. La stessa cautela non è stata applicata in altre lingue.

Questo dimostra come il comportamento dell’IA possa essere localizzato non solo dal punto di vista linguistico, ma anche ideologico, in base alle ipotesi di legge, cultura e pubblico. Senza un’accurata verifica multilingue, le organizzazioni possono inconsapevolmente pubblicare contenuti generati dall’IA che sono fuorvianti, tendenziosi o addirittura non conformi alle normative regionali.

Il nostro ruolo: colmare il divario tra linguaggio e logica

Lo studio conclude che i chatbot alimentati dall’IA non sono ancora strumenti affidabili per la ricerca di informazioni politiche, soprattutto in scenari ad alta tensione come le elezioni. Noi di BBLTranslation siamo d’accordo e è il motivo per cui abbiamo ampliato i nostri servizi per aiutare i clienti a verificare, localizzare e convalidare i risultati generati dall’IA in tutte le lingue.

Non ci limitiamo a tradurre, ma interroghiamo il flusso di informazioni. Analizziamo se le risposte dell’IA:

- Contengono errori di fatto o travisamenti.

- Sono coerenti tra le lingue e i contesti culturali.

- Fornite fonti legittime e verificabili.

- Allinearsi ai valori e alle responsabilità normative dell’organizzazione.

Riflessioni finali: la responsabilità multilingue non è negoziabile

L’IA generativa sarà sempre più integrata nelle piattaforme che utilizziamo quotidianamente. Ma come dimostra questo studio, le sue prestazioni nelle varie lingue rimangono irregolari e, a volte, eticamente discutibili. Se le LLM devono servire il bene pubblico, devono essere tenute a rendere conto del loro operato, non solo in inglese, ma in tutte le lingue che affermano di comprendere.

In BBLTranslation ci troviamo all’intersezione tra linguaggio, tecnologia ed etica. Grazie a verifiche rigorose e all’intuizione linguistica, aiutiamo i clienti a sfruttare il potenziale dell’IA, proteggendo al contempo dalle sue insidie.

Per saperne di più sui nostri servizi di audit dei chatbot AI

Vuoi un’analisi personalizzata sulle risposte del tuo chatbot AI in più lingue? Contattaci per un audit linguistico esperto!

Fonte: Kuai, J., Brantner, C., Karlsson, M., Van Couvering, E., & Romano, S. (2025). La responsabilità dei chatbot AI nell’era del gatekeeping algoritmico: Confronto tra i motori di ricerca generativi per il recupero di informazioni politiche in cinque lingue. New Media & Society, 14614448251321162.

Foto cortesia di Gerd Altmann da Pixabay