L’expertise de BBLTranslation va au-delà des services professionnels de traduction et de localisation. Nous proposons également des audits de performance de chatbots intégrés dans des moteurs de recherche avec intelligence artificielle, aidant nos clients à évoluer dans un paysage numérique en rapide transformation. À mesure que l’IA générative s’intègre dans les moteurs de recherche majeurs, une inquiétude croissante apparaît : comment ces outils se comportent-ils selon la langue et le contexte culturel ?

Une étude récente, évaluée par des pairs et menée par Kuai et al. (2025), met en lumière cette question cruciale. En analysant Microsoft Copilot (anciennement Bing Chat), les chercheurs ont évalué comment le chatbot récupérait des informations politiques durant les élections présidentielles taïwanaises de 2024 dans cinq langues. Résultat ? Des incohérences notables en termes d’exactitude factuelle, d’attribution des sources et de comportement normatif selon la langue utilisée. Cela a de fortes implications pour la responsabilité algorithmique — et pour des organisations comme la nôtre, qui plaçons l’équité linguistique et culturelle au premier plan.

La nature probabiliste des LLM : pas si intelligents qu’ils en ont l’air

Les modèles de langage de grande taille (LLM), comme GPT-4, sont des machines statistiques. Comme l’ont signalé Bender et al. (2021), ce sont des « perroquets stochastiques » : ils génèrent des réponses en fonction des probabilités, non d’une réelle compréhension. Cette nature probabiliste implique des limites : désinformation, biais, et tendance à privilégier les visions du monde dominantes.

En résumé : les LLM ne sont pas neutres. Ils reflètent les cultures, langues et idéologies des données avec lesquelles ils ont été entraînés. Par exemple, Zhou et Zhang (2023) ont constaté que les modèles GPT donnaient des réponses plus pro-chinoises en chinois simplifié qu’en anglais. De même, AI Forensics (2024) a signalé des différences de modération selon la langue durant les élections européennes. Ces constats révèlent que la langue peut modifier profondément le comportement du chatbot, même face à des questions identiques.

BBLTranslation l’a observé directement. Nos audits de chatbots montrent souvent que traduire une même requête donne des réponses différentes, non seulement en ton ou en structure, mais aussi dans le contenu factuel. Pour nos clients internationaux, ces variations peuvent affecter la confiance et la transparence.

Le biais linguistique et les différents comportements de l’IA

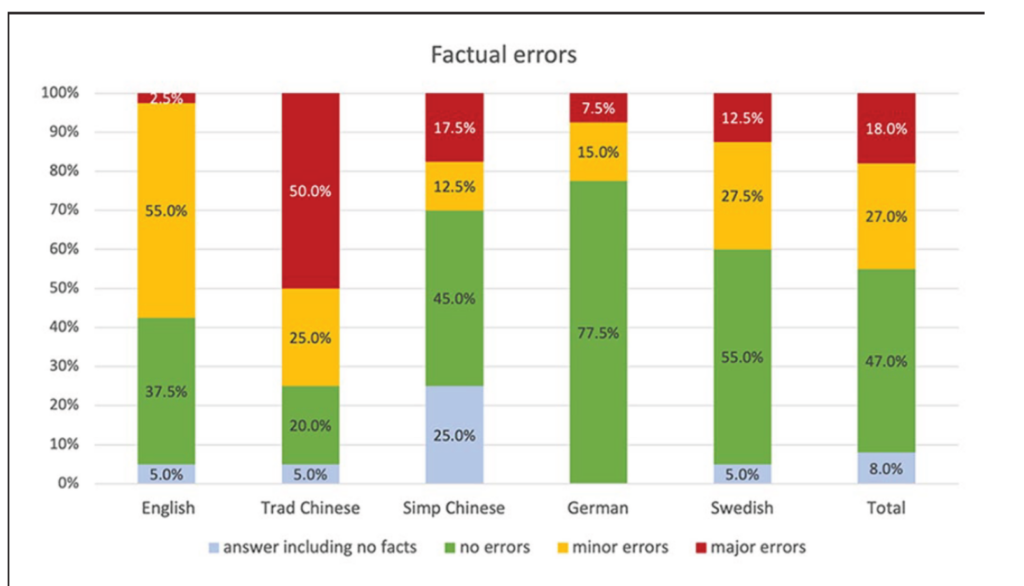

L’étude de Kuai et al. (2025) a examiné les réponses de Copilot à des questions politiques identiques en anglais, chinois traditionnel, chinois simplifié, allemand et suédois. Les résultats sont révélateurs :

- Les requêtes en anglais donnaient des réponses plus cohérentes et détaillées.

- Les réponses en chinois traditionnel contenaient plus d’erreurs factuelles et évitaient les sujets politiques.

- Les réponses en allemand étaient exactes sur le fond, mais biaisées par omission (certains candidats non mentionnés).

- Les réponses en suédois affichaient peu de biais évident, mais une grande variabilité dans la qualité des sources.

Ces différences soulèvent une question essentielle : les systèmes d’IA sont-ils vraiment cohérents entre les langues et cultures ? La réponse est, clairement, non.

Cela renforce le besoin de supervision humaine. BBLTranslation réalise des audits multilingues de contenus IA pour évaluer leur exactitude, neutralité et conformité aux normes démocratiques, surtout dans les contextes sensibles ou réglementés.

La transparence ne garantit pas la responsabilité

Même si de nombreux chatbots fournissent des liens ou des références, cette apparente transparence peut être trompeuse. L’étude révèle que seulement 63 % des contenus liés étaient corrects et bien attribués. Certaines sources étaient mal représentées, mal liées ou même inaccessibles.

Ce niveau d’imprécision serait inacceptable dans le journalisme ou l’académie, mais il passe souvent inaperçu dans les outils IA. Chez BBLTranslation, nous appelons cela une transparence performative. Nos audits ne vérifient pas seulement si des sources sont citées, mais aussi si ces citations sont vraies, précises et culturellement pertinentes dans toutes les langues.

Le contexte culturel et les sensibilités légales comptent

Les variations linguistiques reflètent aussi les normes culturelles et les cadres juridiques. Par exemple, en chinois simplifié, le chatbot a refusé de donner des données de sondage, citant une loi taïwanaise interdisant leur publication avant les élections. Cette précaution n’a pas été observée dans d’autres langues.

Cela prouve que le comportement de l’IA est localisé non seulement linguistiquement, mais aussi idéologiquement, selon des suppositions sur la loi, la culture et le public. Sans audits multilingues rigoureux, les organisations risquent de publier du contenu biaisé, inexact ou même illégal.

Notre rôle : faire le lien entre le langage et la logique

L’étude conclut que les chatbots LLM ne sont pas encore fiables pour l’information politique, notamment dans des contextes sensibles. BBLTranslation le sait bien : c’est pourquoi nous proposons des services d’audit, de localisation et de validation de contenu IA dans plusieurs langues.

Nous ne faisons pas que traduire ; nous analysons la circulation de l’information. Nous évaluons si les réponses de l’IA :

- contiennent des erreurs factuelles ou des déformations,

- sont cohérentes entre langues et cultures,

- fournissent des sources fiables et vérifiables,

- sont alignées sur les valeurs de votre organisation et les normes applicables.

Réflexion finale : la relecture humaine multilingue est indispensable

L’IA générative sera de plus en plus omniprésente dans nos plateformes. Mais comme le montre cette étude, ses performances selon les langues sont encore inégales et parfois éthiquement problématique. Si les LLM doivent servir l’intérêt général, ils doivent être responsables dans toutes les langues qu’ils prétendent comprendre.

BBLTranslation travaille à l’intersection du langage, de la technologie et de l’éthique. Avec des audits rigoureux et une sensibilité linguistique, nous aidons nos clients à exploiter le potentiel de l’IA sans en ignorer les risques.

En savoir plus sur l’audit de chatbots IA

Vous souhaitez une analyse personnalisée des réponses de votre chatbot IA dans plusieurs langues ? Contactez-nous pour un audit linguistique expert !

Source : Kuai, J., Brantner, C., Karlsson, M., Van Couvering, E., & Romano, S. (2025). AI chatbot accountability in the age of algorithmic gatekeeping: Comparing generative search engine political information retrieval across five languages. New Media & Society, 14614448251321162.

Photo : courtoisie de Gerd Altmann via Pixabay.