En BBLTranslation, nuestra experiencia va más allá de los servicios profesionales de traducción y localización. También ofrecemos auditorías de rendimiento de chatbots integrados en motores de búsqueda con inteligencia artificial, ayudando a nuestros clientes a desenvolverse en un panorama digital en rápida evolución. A medida que la inteligencia artificial generativa se integra en los principales buscadores, surge una preocupación cada vez mayor: cómo se comportan estas herramientas según el idioma y el contexto cultural.

Un estudio reciente, revisado por pares y realizado por Kuai et al. (2025), arroja luz sobre esta cuestión crucial. Analizando Microsoft Copilot (anteriormente Bing Chat), los investigadores evaluaron cómo el chatbot recuperaba información política durante las elecciones presidenciales de Taiwán de 2024 en cinco idiomas. ¿El resultado? Incoherencias significativas en cuanto a exactitud factual, atribución de fuentes y comportamiento normativo, dependiendo del idioma utilizado. Esto tiene importantes implicaciones para la responsabilidad algorítmica —y para organizaciones como la nuestra, que priorizamos la equidad lingüística y cultural.

La naturaleza probabilística de los LLM: no son tan inteligentes como parecen

Los modelos de lenguaje de gran tamaño (LLM), como GPT-4, son máquinas estadísticas. Como señalaron Bender et al. (2021), son “loros estocásticos”: generan respuestas en función de patrones de probabilidad, no de comprensión real. Esta naturaleza probabilística introduce limitaciones inherentes: desinformación, sesgo y la tendencia a privilegiar las visiones del mundo dominantes.

En resumen: los LLM no son neutrales. Reflejan las culturas, los idiomas y las ideologías de los datos con los que fueron entrenados. Por ejemplo, Zhou y Zhang (2023) descubrieron que los modelos GPT ofrecían respuestas más pro-chinas en chino simplificado que en inglés. De manera similar, AI Forensics (2024) denunció diferencias en la moderación según el idioma durante las elecciones europeas. Estas observaciones revelan cómo el idioma puede modificar drásticamente el comportamiento del chatbot, incluso ante preguntas idénticas.

En BBLTranslation hemos comprobado esto de primera mano. Nuestras auditorías de chatbots suelen revelar cómo las traducciones de una misma consulta generan respuestas diferentes, no solo en tono o estructura, sino también en contenido factual. Para nuestros clientes internacionales, estas variaciones pueden minar la confianza y la transparencia.

Sesgo lingüístico y diferencias de comportamiento en la IA

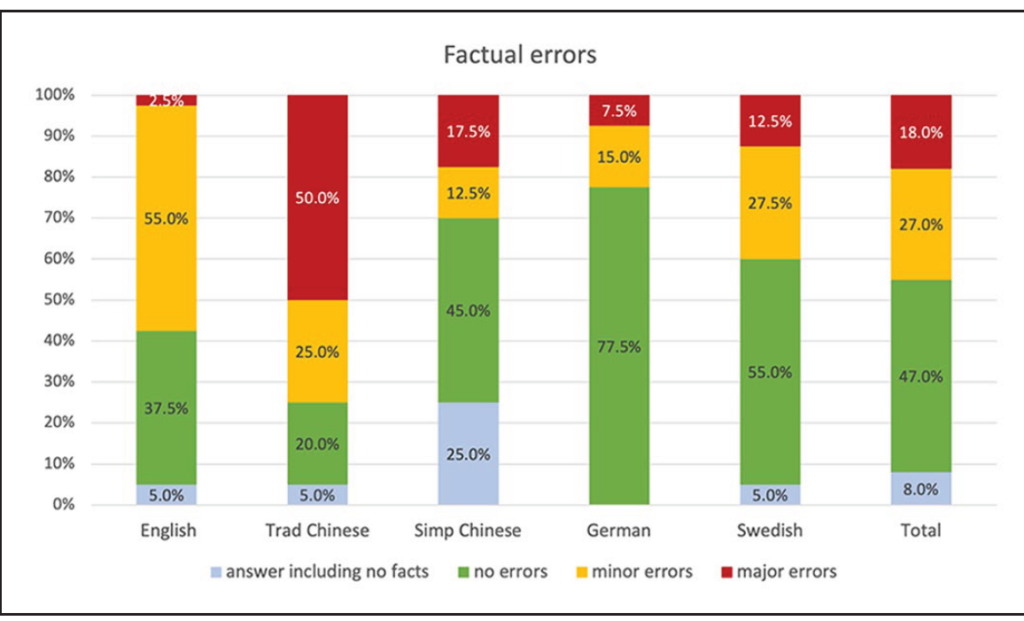

El estudio de Kuai et al. (2025) examinó cómo Copilot respondía a las mismas preguntas políticas en inglés, chino tradicional, chino simplificado, alemán y sueco. Los resultados fueron reveladores:

- Las consultas en inglés ofrecían respuestas más coherentes y detalladas.

- Las respuestas en chino tradicional eran más propensas a contener errores factuales y evitaban hablar de temas políticos.

- Las respuestas en alemán eran correctas desde el punto de vista factual, pero mostraban sesgo por omisión, dejando de mencionar a ciertos candidatos.

- Las respuestas en sueco mostraban menos sesgo evidente, pero una variabilidad considerable en la calidad de las fuentes.

Estas diferencias plantean una pregunta esencial: ¿son los sistemas de IA realmente consistentes entre idiomas y culturas? La respuesta es, claramente, no.

Esto refuerza la necesidad de una supervisión profesional. En BBLTranslation, realizamos auditorías multilingües del contenido generado por IA para evaluar su precisión, neutralidad y alineación con normas democráticas, especialmente en contextos sensibles o regulados.

La transparencia no garantiza la responsabilidad

Aunque muchos chatbots ofrecen hipervínculos y referencias, esta apariencia de transparencia puede ser engañosa. El estudio halló que solo el 63 % del contenido enlazado era correcto y atribuía la fuente adecuadamente. Algunas fuentes estaban mal representadas, otras mal enlazadas o incluso rotas.

Este nivel de imprecisión sería inaceptable en el periodismo o la academia, pero a menudo pasa desapercibido en las herramientas de IA. En BBLTranslation lo llamamos transparencia performativa. Nuestras auditorías no solo comprueban si se citan fuentes, sino si esas citas son veraces, precisas y culturalmente pertinentes en todos los idiomas.

El contexto cultural y las sensibilidades legales importan

Las diferencias por idioma también reflejan las normas culturales y los marcos legales. Por ejemplo, en chino simplificado, el chatbot evitó proporcionar datos de encuestas, citando una ley taiwanesa que prohíbe su publicación antes de las elecciones. Esta precaución no se aplicó en otros idiomas.

Esto demuestra que el comportamiento de la IA no solo se localiza lingüísticamente, sino también ideológicamente, condicionado por supuestos sobre la ley, la cultura y el público. Sin auditorías multilingües rigurosas, las organizaciones corren el riesgo de publicar contenido sesgado, inexacto o incluso ilegal.

Nuestro papel: tender puentes entre lenguaje y lógica

El estudio concluye que los chatbots con LLM no son aún herramientas fiables para obtener información política, especialmente en contextos de alta sensibilidad. En BBLTranslation lo sabemos bien: por eso ofrecemos servicios para auditar, localizar y validar contenidos generados por IA en múltiples idiomas.

No solo traducimos; analizamos el flujo informativo. Evaluamos si las respuestas de la IA:

- Contienen errores factuales o tergiversaciones.

- Son coherentes entre idiomas y contextos culturales.

- Proporcionan fuentes legítimas y verificables.

- Están alineadas con los valores de tu organización y la normativa aplicable.

Reflexión final: la revisión humana multilingüe es imprescindible

La IA generativa será cada vez más omnipresente en las plataformas que usamos a diario. Pero como demuestra este estudio, su rendimiento entre idiomas sigue siendo errático y, a veces, éticamente cuestionable. Si los LLM han de servir al bien común, deben ser responsables en todos los idiomas que dicen entender.

En BBLTranslation, trabajamos en la intersección entre lenguaje, tecnología y ética. Con auditorías rigurosas y sensibilidad lingüística, ayudamos a nuestros clientes a aprovechar el potencial de la IA sin perder de vista sus riesgos.

Saber más sobre la auditoría de los chatbots de IA

¿Quieres un análisis personalizado de las respuestas de tu chatbot con IA en varios idiomas? Contáctanos para una auditoría lingüística experta!

Fuente: Kuai, J., Brantner, C., Karlsson, M., Van Couvering, E., & Romano, S. (2025). AI chatbot accountability in the age of algorithmic gatekeeping: Comparing generative search engine political information retrieval across five languages. New Media & Society, 14614448251321162.

Foto cortesía de Gerd Altmann desde Pixabay